Сегодня разберёмся что такое индекс, как в него попасть, а когда лучше закрыть сайт от индексации. Я расскажу о 5 простых способах, с которыми справится даже новичок. Познакомимся поближе с поисковыми роботами и научимся общаться с ними.

Индексация простыми словами

Чтобы пользователи интернета смогли найти проект по какому-то запросу в поиске, он должен предварительно попасть в общую базу данных (индекс). Этот процесс добавления страницы в базу называется индексацией и производится роботами (автоматизированными программами) поисковой машины.

Роботы (они же веб-пауки, краулеры, боты) заходят на ресурс и сканируют доступные страницы, изображения, видео и другие файлы. Полученные данные собираются в поисковый индекс, а затем из этой базы берутся результаты для выдачи информации пользователям.

Также краулеры собирают ссылки с вашего проекта для дальнейшей их обработки. Из этого следует, что оставляя ссылки на свой ресурс в других сервисах (сайтах, форумах, социальных сетях), вы привлекаете поисковых ботов на свой сайт и ускоряете процесс индексации.

Веб-краулеры разных поисковых систем работают по-разному. Кроме того, алгоритмы сканирования (краулинга) и обработки данных совершенствуются с каждым годом.

Максимально работайте над уникальностью контента, структурностью, полезностью ресурса. Если веб-паук не нашёл интересной новой информации, то страница может и не проиндексироваться. Другими словами, статья была просканирована, но в индекс (а значит и в поисковую выдачу) не попала.

За раз краулер сканирует только несколько страниц, чтобы не создавать нагрузку на сервер своими запросами. На новостные порталы, которые постоянно обновляются, боты заходят очень часто и наоборот: если сайт заброшен, то и «гости» заходят редко.

Очень важно вести работу системно, обновляя периодически старые записи. Очень помогают в этом смысле комментарии, которые оставляют читатели. Проект, на котором ведутся дискуссии, привлекает внимание поисковых роботов, он становится более интересным и лучше продвигается.

Нужно ли индексировать новый сайт

Представим себе начинающего вебмастера, который создаёт свой первый проект. Хорошо, если у него есть наставник, который быстро научит всем тонкостям этого процесса. Как правило, это входит в платный пакет обучения. В реальности большинство «учеников» разбираются самостоятельно, а это потеря времени, ошибки, переделки.

А теперь представьте, что робот пришёл на новоиспечённый сайт, проиндексировал его. Владелец же каждый день усовершенствуете своё детище: улучшаете структуру, работает над заголовками, меняет ключевые слова… Вдруг пользователь находит и кликает ссылку в поиске, а данная страница уже не существует… Клиент расстроится и возможно в следующий раз выберет сайт конкурента.

Поисковые системы (ПС) тоже с недоверием относятся к ресурсам, в которых много битых (несуществующих) ссылок. Это так называемая ошибка 404 (Not Found, «не найдено»).

Разумнее на период экспериментов и разработки закрыть сайт от индексации, чтобы не путать людей и ботов а также не засорять интернет мёртвыми ссылками. Или нужно делать редиректы, хотя вряд ли новичок будет во всё это вникать на первых этапах.

Как запретить индексирование

Причины, по которым лучше закрыть сайт от индексации, могут быть разными:

- ресурс не готов к показу, например, находится на стадии создания или кардинальных изменений;

- проект предназначен для ограниченного круга лиц;

- содержит платный материал;

- архивы (устаревшая информация) могут быть вынесены на отдельный поддомен и не ранжироваться в поиске.

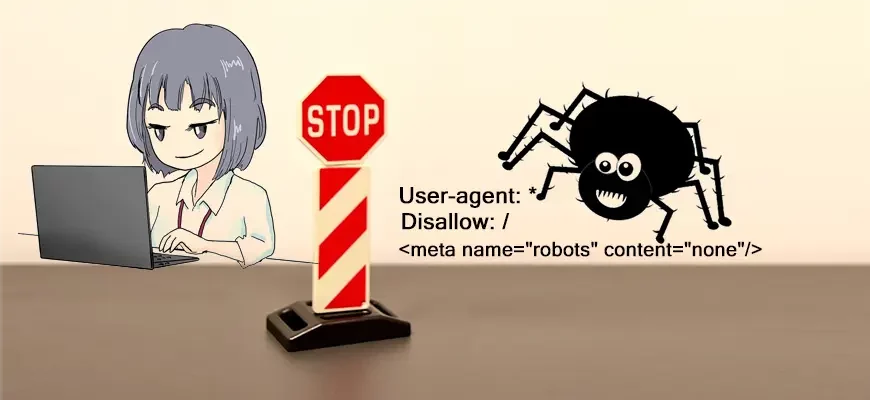

Есть несколько способов попробовать «договориться с краулерами» и закрыть сайт от индексации. Давайте разберёмся с ними, но помните, что одновременное применение нескольких вариантов может привести к конфликту. Поэтому сначала изучите, а потом примените подходящий способ.

С помощью robots.txt

Каждый современный сайт должен содержать специальный текстовый файл robots.txt с набором инструкций для ПС. Краулеры сначала скачивают и анализируют его, получают указания, что можно сканировать, а что — нет.

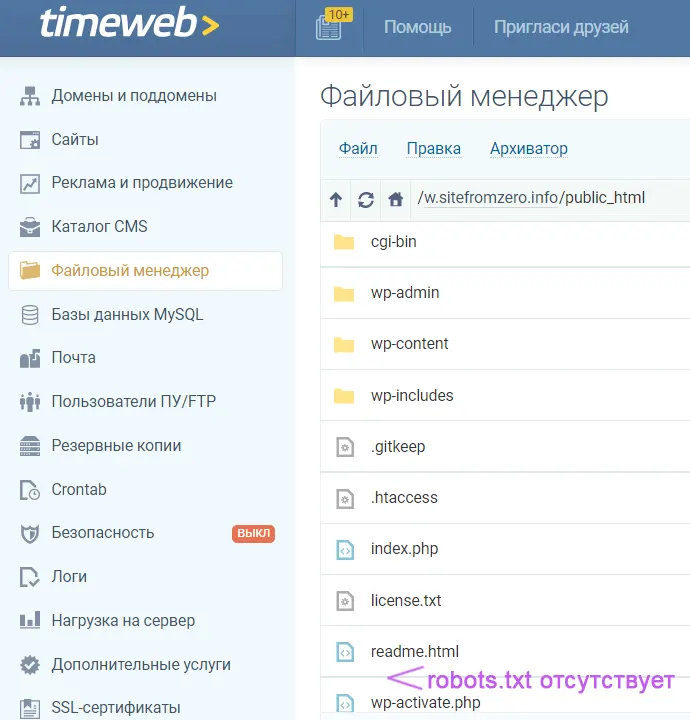

Для начала нужно проверить, возможно он уже есть а также убедиться в его общедоступности. Для этого введите в поиск в режиме инкогнито подобный адрес:

https://sitefromzero.info/robots.txt

Если такого файла не оказалось, то создайте его в текстовом редакторе (лучше Notepad++), точно указав название (обязательно с маленькой буквы). Теперь добавьте правило для поисковых ботов в виде кода:

User-agent: *

Disallow: /Сохраните файл в кодировке UTF-8 в корневую папку сайта, иначе роботы его просто не поймут или не найдут.

Пояснения к коду:

- User-agent — так мы обращаемся к поисковому роботу (агенту пользователя). Звёздочка означает, что мы обращаемся сразу ко всем поисковикам. Если хотите пообщаться с кем-то конкретно, то укажите имя бота, например

User-agent: Googlebot

или

User-agent: YandexGooglebot и Yandex — это основные роботы-индексаторы от Google и Яндекса.

- Disallow: — директива (правило), указывающая какие пути не должны сканироваться.

- Allow: — директива, указывающая какие пути можно сканировать.

По умолчанию роботу разрешено сканировать всё, что не запрещено директивой Disallow:. Строка обязательно должна начинаться с косой линии. Обратите внимание, упустив лишь один символ, вы откроете проект для индексации:

User-agent: *

Disallow:Нужно понимать, что robots.txt не запрещает, а лишь указывает поисковикам какую информацию обрабатывать, а какую — нет. Большинство ботов следуют установленным директивам, однако некоторые пауки могут проигнорировать правила.

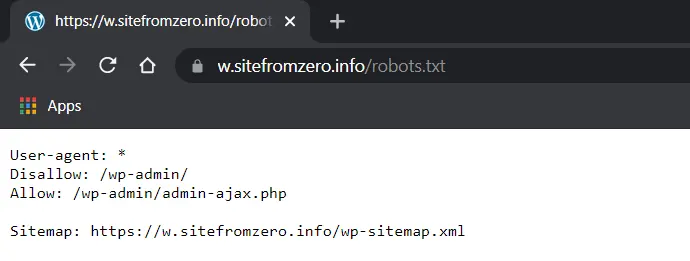

Если у вас новенький проект на CMS WordPress, то такой файл уже есть, правда он виртуальный. В корневой папке вы его не найдёте.

Но он работает, открывается по нужному адресу и выглядит так.

Отредактировать этот файл можно с помощью популярных плагинов: Clearfy, ClearfyPro, Rank Math, Yoast SEO. А лучше создать фактический robots.txt и разместить его в корневую папку сайта. Роботам без разницы реальный он или виртуальный, выбор только за вами.

На сайте должен быть только один robots.txt.

С помощью мета-тега robots

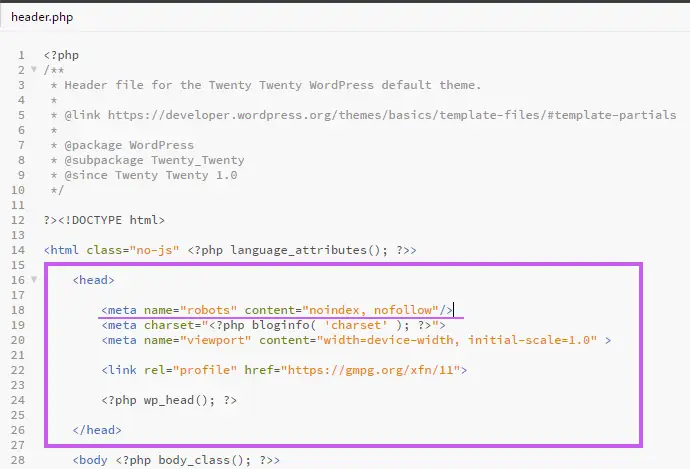

Более строгий вариант закрыть сайт от индексации: прописать мета-тег в исходный код, а именно в файле index.html в контейнере <head>:

<meta name="robots" content="noindex, nofollow"/>или

<meta name="robots" content="none"/>Давайте разберёмся что это значит:

- robots — обращаемся ко всем ботам;

- noindex — запрет на индексацию контента;

- nofollow — запрет на индексацию ссылок;

- none — запрет на индексацию контента и ссылок.

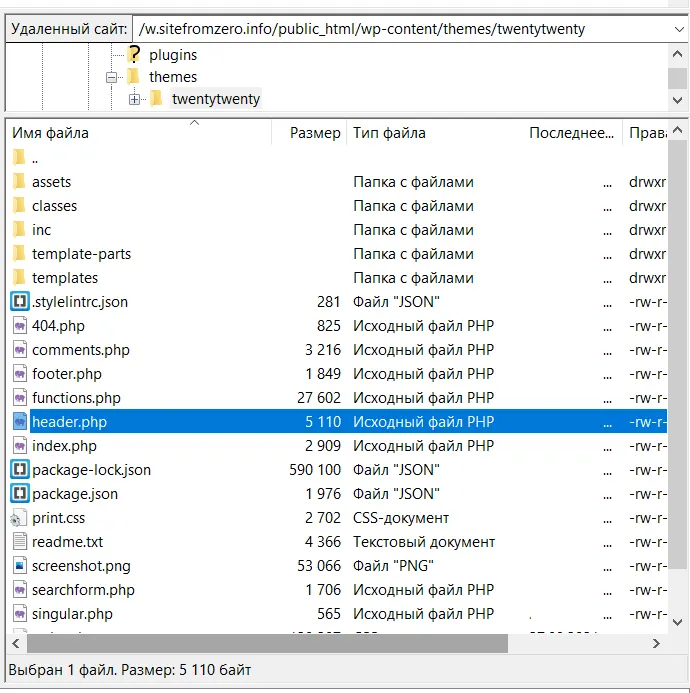

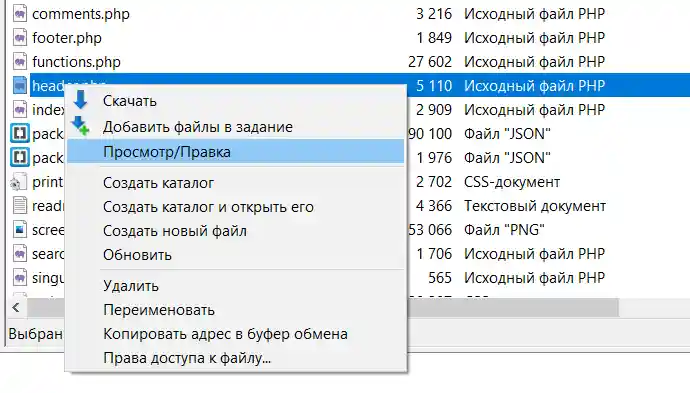

Если сайт создан на WordPress, то этот шаг делайте только после установки шаблона, поскольку <head> находится непосредственно в папке «Themes» и нужно выбрать header.php именно вашей темы. Путь к данному файлу выглядит так.

Ваш сайт/public_html/wp-content/themes/Ваша тема

Покажу на примере стандартной WP-темы TwentyTwenty.

Правой мышкой выберите режим Просмотр / Правка.

В открывшемся файле вверху находим <head> и вставляем код.

Все правки кода рекомендуется делать в дочерней теме, поскольку при обновлении родительской изменения пропадут.

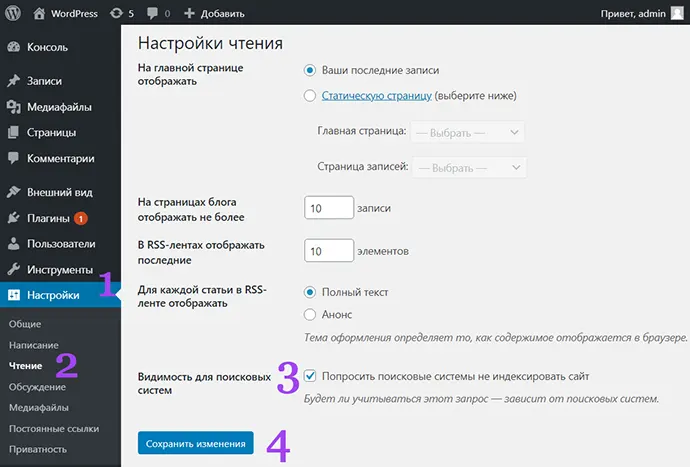

В админ-панели WP

Попросить поисковые системы не индексировать сайт можно прямо с админ-панели WordPress. Для этого зайдите в Настройки / Чтение и поставьте галочку в пункте «Видимость для поисковых систем».

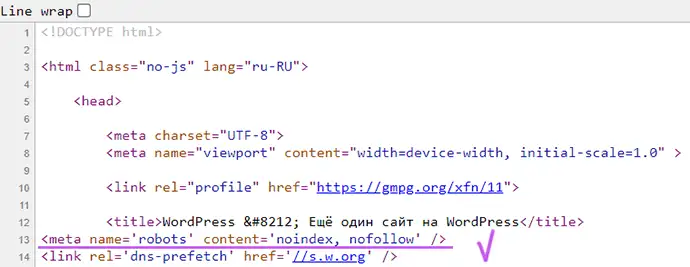

При этом автоматически прописывается мета-тег robots, в чём легко убедиться нажав Ctrl+U.

Это самый простой и быстрый способ закрыть сайт от индексации, однако не забывайте, что и он не даёт 100% гарантии.

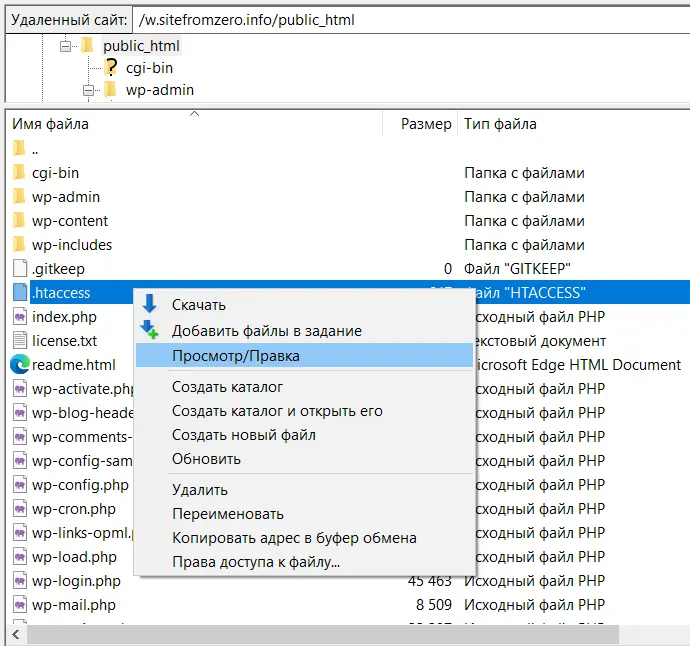

Через файл .htaccess

Если же роботы не реагируют на предыдущие методы, то можно внести изменения на уровне сервера с помощью служебного файла.

Он начинается с точки и не является непосредственно файлом сайта, а служит для настроек веб-сервера. При установке WordPress сам создаёт .htaccess («hypertext access») в корневой папке. Вы можете отредактировать его непосредственно в панели управления хостингом или через FTP, используя FileZilla.

В этом случае прописывается запрет для каждой поисковой системы.

SetEnvIfNoCase User-Agent "^Yandex" search_bot

SetEnvIfNoCase User-Agent "^Googlebot" search_bot

SetEnvIfNoCase User-Agent "^Yahoo" search_bot

SetEnvIfNoCase User-Agent "^igdeSpyder" search_bot

SetEnvIfNoCase User-Agent "^Robot" search_bot

SetEnvIfNoCase User-Agent "^msnbot" search_bot

SetEnvIfNoCase User-Agent "^Aport" search_bot

SetEnvIfNoCase User-Agent "^Mail" search_bot

SetEnvIfNoCase User-Agent "^bot" search_bot

SetEnvIfNoCase User-Agent "^spider" search_bot

SetEnvIfNoCase User-Agent "^php" search_bot

SetEnvIfNoCase User-Agent "^Snapbot" search_bot

SetEnvIfNoCase User-Agent "^WordPress" search_bot

SetEnvIfNoCase User-Agent "^BlogPulseLive" search_bot

SetEnvIfNoCase User-Agent "^Parser" search_botЭто достаточно жёсткий метод блокировки, используемый опытными вебмастерами.

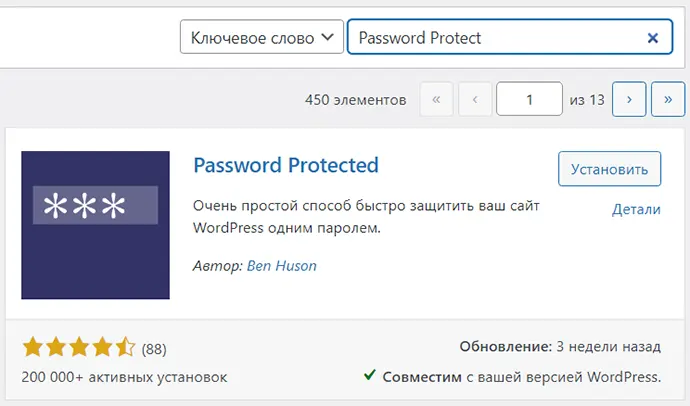

Установить пароль на весь сайт

Самый надёжный способ закрыть сайт от индексации — установить пароль. Есть несколько плагинов WordPress, наиболее простой и популярный — Password Protected.

Администратор и зарегистрированные пользователи могут входить без пароля.

Как проверить какие страницы попали в поиск

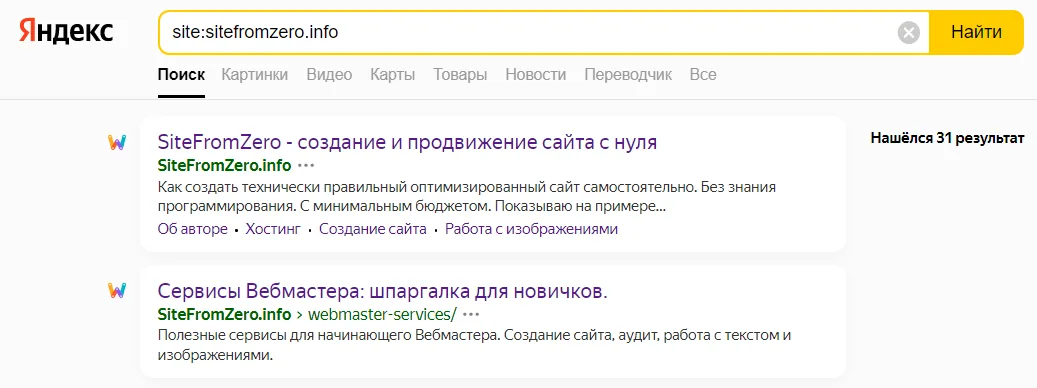

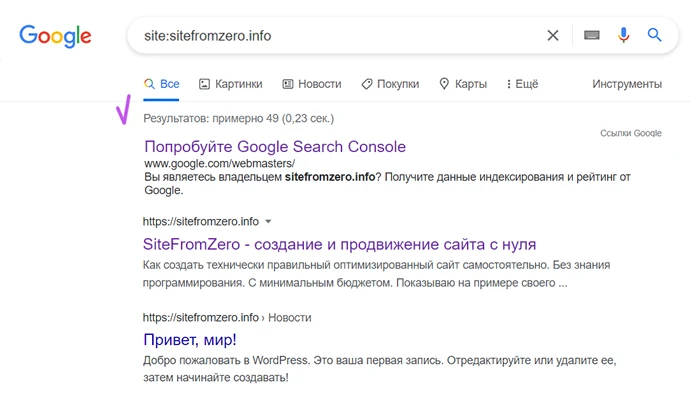

Иногда так случается, что несмотря на запрет нежелательный контент попал в выдачу. Для проверки индексации всего проекта можно воспользоваться поисковым оператором [site:]. Этот способ наиболее простой, но не очень точный.

В строку поиска Google и Яндекса нужно ввести такой запрос: site:domain.info

При запросе в Яндексе я получила 31 результат.

При аналогичном запросе в Google получила гораздо больше проиндексированных страниц. Среди них оказались удалённые страницы, например первая пробная статья «Привет, мир!», которая шла вместе с загрузкой WordPress.

Как видите, Yandex достаточно послушен и придерживается правил, чего не скажешь о Googlebot. Так что не думайте, что проект никто не найдёт. Если вы открыли его в браузере, этого уже достаточно, чтобы «засветиться».

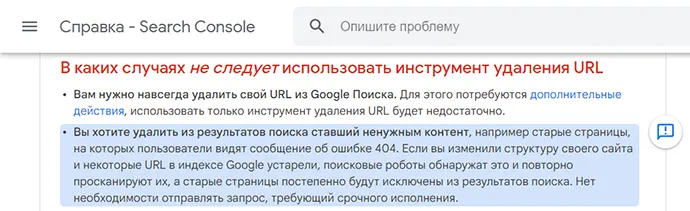

Как удалить страницу из поиска

Если проект только создан и там нет важной информации в виде персональных данных, то можно ничего не делать, а просто подождать пока краулеры сами выявят несуществующие страницы и удалят их из поиска.

Сам Google просит не создавать срочных запросов на удаление URL, если лишние страницы возникли в результате изменения структуры сайта.

Если необходимо срочно удалить URL, то воспользуйтесь специальными инструментами в кабинетах Вебмастера от Google и Яндекс. Как это сделать, я подробно опишу в новом обзоре.

Итак, теперь вы знаете несколько простых способов как закрыть сайт от индексации, главное не забудьте потом открыть доступ. Советую дополнительно изучить рекомендации от Google и Яндекс.

В некоторых случаях требуется запретить индексацию не всего проекта, а только его отдельные страницы или элементы. Об этом мы поговорим в другой раз. Подписывайтесь на обновления, чтобы не пропустить новые публикации.

Добрый день.

Светлана, огромное спасибо Вам за столь качественную статью.

Так сказать, понятным языком о неизвестном. Обязательно буду пользоваться данной информацией.

С огромным удовольствием подписался на Ваш блог.

Пользуясь Вашим предложением о помощи в пошаговой инструкции создания блога, прошу проанализировать и дать оценку моему первому проекту aromaterapevt.com

Отзыв можно оставить в разделе контакты.

Благодарен Вам за великолепный проект sitefromzero.info на котором столько полезной информации!

Благодарю за отзыв. Я посмотрела проект, вы проделали большую работу как начинающий вебмастер и я желаю дальнейшего улучшения и развития ему. Я бы посоветовала уделить больше внимания внешнему виду (логотип, шрифты, структура…) и безопасности. Особенно второму, защитите сайт от перебора паролей и не дайте возможности хакерам взломать его. Ваши технические страницы лучше закрыть от индексации.

Спасибо за полезную статью. Сам имею сайт, поэтому понимаю в чем суть!

Пожалуйста, Валерий. Делитесь своим личным опытом)

Спасибо! Статья очень подробная. Всё получилось настроить с первого раза. Действительно, главное — не забыть потом отключить.)

Пожалуйста. Желаю плодотворной работы.

Спасибо за статью! Буду рад применить эти знания для настройки индексации!

Пожалуйста, желаю плодотворной работы над проектом.

Спасибо, очень выручили

Пожалуйста)

Очень полезная, информативная статья. Все наглядно и подробно, спасибо!

Пожалуйста, Виктория. Рада, что получилось изложить непростой материал доступным языком.