Сьогодні розберемося, що таке індекс, як до нього потрапити, а коли краще закрити сайт від індексації. Я розповім про 5 простих способів, з якими впорається навіть новачок. Познайомимося ближче з пошуковими роботами та навчимося спілкуватися з ними.

Індексація простими словами

Щоб користувачі інтернету змогли знайти проект за якимось запитом у пошуку, він має попередньо потрапити до загальної бази даних (індексу). Цей процес додавання сторінки до бази називається індексацією і виконується роботами (автоматизованими програмами) пошукової машини.

Роботи (вони ж веб-павуки, краулери, роботи) заходять на ресурс і сканують доступні сторінки, зображення, відео та інші файли. Отримані дані збираються в пошуковий індекс, а потім із цієї бази беруться результати для видачі інформації користувачам.

Також краулери збирають посилання з вашого проекту для подальшої їх обробки. З цього випливає, що залишаючи посилання на свій ресурс в інших сервісах (сайтах, форумах, соціальних мережах) ви залучаєте пошукових ботів на свій сайт і прискорюєте процес індексації.

Веб-краулери різних пошукових систем працюють по-різному. Крім того, алгоритми сканування (краулінгу) та обробки даних удосконалюються з кожним роком.

Максимально працюйте над унікальністю контенту, структурністю, корисністю ресурсу. Якщо веб-павук не знайшов цікавої нової інформації, сторінка може і не проіндексуватися. Іншими словами, стаття була просканована, але в індекс (а отже, і в пошукову видачу) не потрапила.

За один раз краулер сканує лише кілька сторінок, щоб не створювати навантаження на сервер своїми запитами. На портали новин, які постійно оновлюються, боти заходять дуже часто і навпаки: якщо сайт занедбаний, то і «гості» заходять рідко.

Дуже важливо вести роботу системно, періодично оновлюючи старі записи. Дуже допомагають у цьому розумінні коментарі, які залишають читачі. Проект, на якому ведуться дискусії, привертає увагу пошукових роботів, він стає цікавішим і краще просувається.

Чи потрібно індексувати новий сайт

Уявімо вебмайстра початківця, який створює свій перший проект. Добре, якщо в нього є наставник, який швидко навчить усім тонкощам цього процесу. Як правило, це входить до платного пакета навчання. Насправді більшість «учнів» розбираються самостійно, а це втрата часу, помилки, переробки.

А тепер уявіть, що робот прийшов на новий сайт, проіндексував його. Власник же щодня удосконалюєте своє дітище: покращуєте структуру, працює над заголовками, змінює ключові слова… Раптом користувач знаходить і кликає посилання в пошуку, а ця сторінка вже не існує… Клієнт засмутиться і можливо наступного разу вибере сайт конкурента.

Пошукові системи (ПС) також з недовірою ставляться до ресурсів, у яких багато битих (неіснуючих) посилань. Це так звана помилка 404 (Not Found, “не знайдено”).

Розумніше на період експериментів та розробки закрити сайт від індексації, щоб не плутати людей та ботів, а також не засмічувати інтернет мертвими посиланнями. Або треба робити редиректи, хоча навряд чи новачок буде все це вникати на перших етапах.

Як заборонити індексування

Причини, з яких краще закрити сайт від індексації, можуть бути різними:

- ресурс не готовий до показу, наприклад, знаходиться на стадії створення чи кардинальних змін;

- проект призначений для обмеженого кола осіб;

- містить платний матеріал;

- архіви (застаріла інформація) можуть бути винесені на окремий піддомен і не ранжуватися у пошуку.

Є кілька способів спробувати «договоритися з краулерами» та закрити сайт від індексації. Давайте розберемося з ними, але пам’ятайте, що одночасне застосування кількох варіантів може призвести до конфлікту. Тому спочатку вивчіть, а потім застосуйте відповідний спосіб.

За допомогою robots.txt

Кожен сучасний сайт має містити спеціальний текстовий файл robots.txt із набором інструкцій для ПС. Краулер спочатку скачують і аналізують його, отримують вказівки, що можна сканувати, а що – ні.

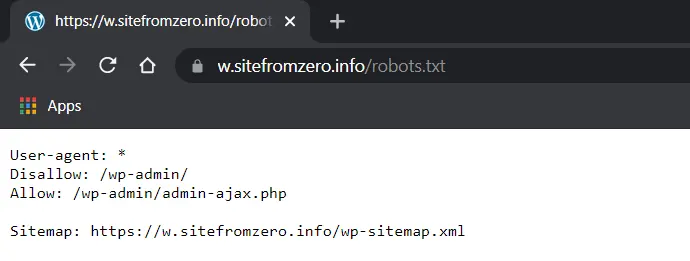

Для початку потрібно перевірити, чи можливо він вже є і переконатися в його загальнодоступності. Для цього введіть у пошук в режимі інкогніто подібну адресу:

https://sitefromzero.info/robots.txt

Якщо такого файлу не виявилося, створіть його в текстовому редакторі (краще Notepad++), точно вказавши назву (обов’язково з маленької літери). Тепер додайте правило для пошукових роботів у вигляді коду:

User-agent: *

Disallow: /Збережіть файл у кодуванні UTF-8 у кореневу папку сайту, інакше роботи його просто не зрозуміють чи не знайдуть.

Пояснення до коду:

- User-agent – так ми звертаємося до пошукового робота (агента користувача). Зірочка означає, що ми звертаємося відразу до всіх пошукових систем. Якщо хочете поспілкуватися з кимось конкретно, вкажіть ім’я бота, наприклад

User-agent: Googlebot

або

User-agent: YandexGooglebot и Yandex – це основні роботи-індексатори від Google та Яндекса.

- Disallow: – директива (правило), яка вказує на шляхи,які не повинні скануватися.

- Allow: – директива, яка вказує які шляхи можна сканувати.

За промовчанням роботу дозволено сканувати все, що не заборонено директивою Disallow:. Рядок обов’язково має починатися з косої лінії. Зверніть увагу, упустивши лише один символ, ви відкриєте проект для індексації:

User-agent: *

Disallow:Нужно понимать, что robots.txt не запрещает, а лишь указывает поисковикам какую информацию обрабатывать, а какую – нет. Большинство ботов следуют установленным директивам, однако некоторые пауки могут проигнорировать правила.

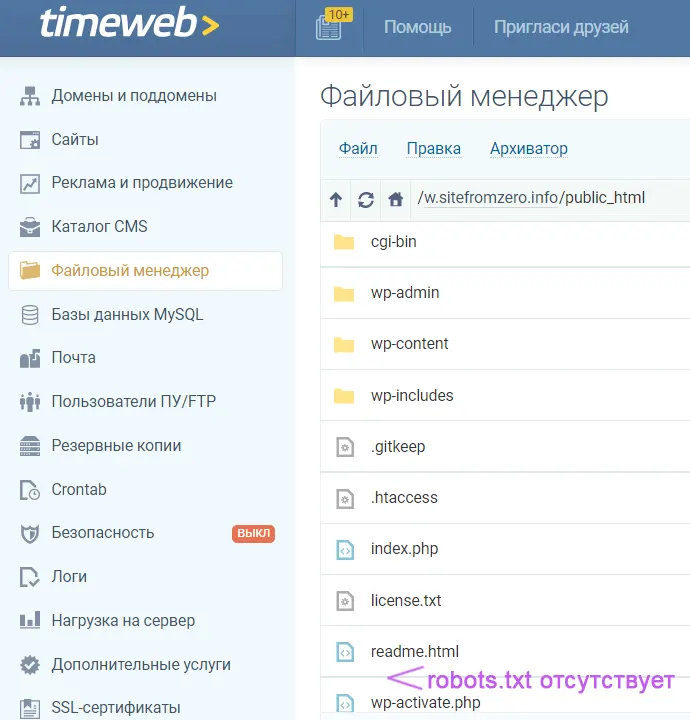

Якщо у вас новий проект на CMS WordPress, то такий файл вже є, правда він віртуальний. У кореневій папці ви його не знайдете.

Але він працює, відкривається за потрібною адресою і виглядає так.

Відредагувати цей файл можна за допомогою популярних плагінів: Clearfy, ClearfyPro, Rank Math, Yoast SEO. А краще створити фактичний robots.txt та розмістити його у кореневу папку сайту. Роботам все одно реальний він або віртуальний, вибір тільки за вами.

На сайті має бути лише один robots.txt.

За допомогою мета-тегу robots

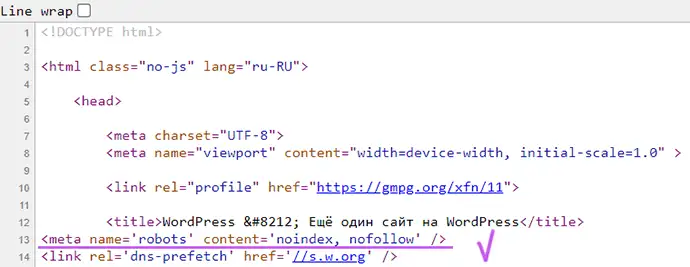

Суворіший варіант закрити сайт від індексації: прописати мета-тег у код, а саме у файлі index.html у контейнері <head>:

<meta name="robots" content="noindex, nofollow"/>або

<meta name="robots" content="none"/>Давайте розберемося що це означає:

- robots – звертаємося до всіх ботів;

- noindex – заборона на індексацію контенту;

- nofollow – заборона на індексацію посилань;

- none – заборона на індексацію контенту та посилань.

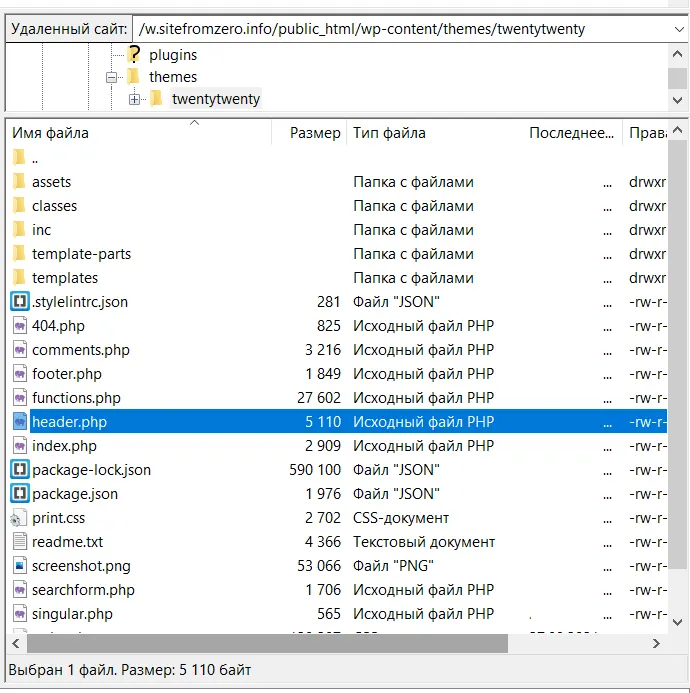

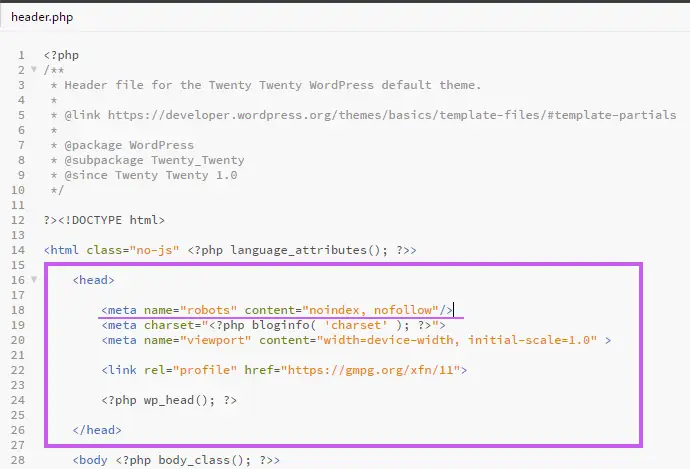

Якщо сайт створений на WordPress, цей крок робіть тільки після встановлення шаблону, оскільки <head> знаходиться безпосередньо у папці «Themes» і потрібно вибрати header.php саме вашої теми. Шлях до файлу виглядає так.

Ваш сайт/public_html/wp-content/themes/Ваша тема

Покажу на прикладі стандартної WP-теми TwentyTwenty.

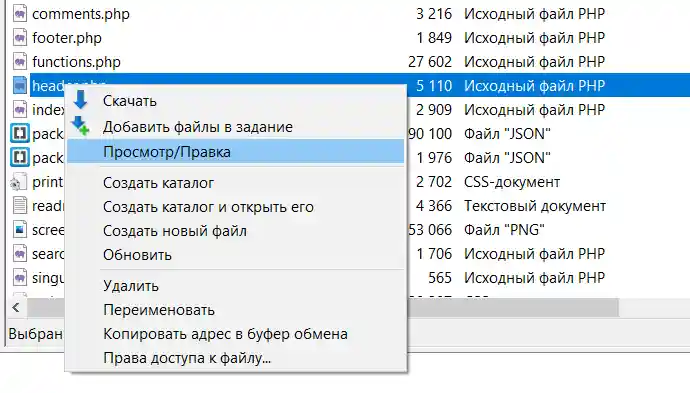

Правою мишкою виберіть режим Перегляд / Редагування.

У файлі, що відкрився, вгорі знаходимо <head> та вставляємо код.

Всі редагування коду рекомендується робити в дочірній темі, оскільки при оновленні батьківської зміни пропадуть.

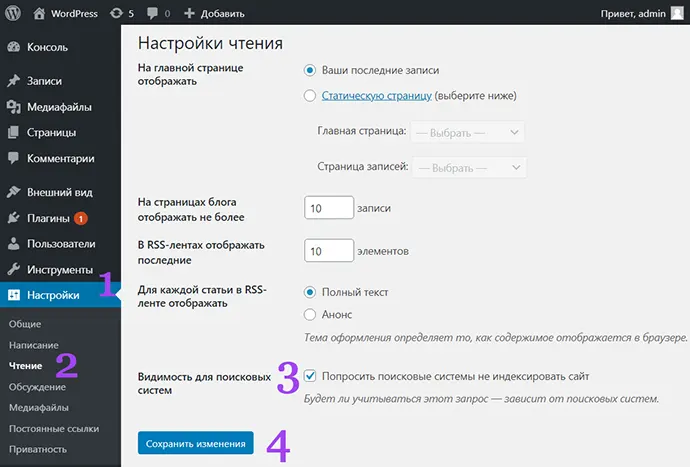

В адмін-панелі WP

Попросити пошукові системи не індексувати сайт можна прямо з адмін-панелі WordPress. Для цього зайдіть в Налаштування / Читання та поставте галочку в пункті «Видимість для пошукових систем».

При цьому автоматично прописується мета-тег robots, в чому легко переконатися, натиснувши Ctrl+U.

Це найпростіший і найшвидший спосіб закрити сайт від індексації, проте не забувайте, що і він не дає 100% гарантії.

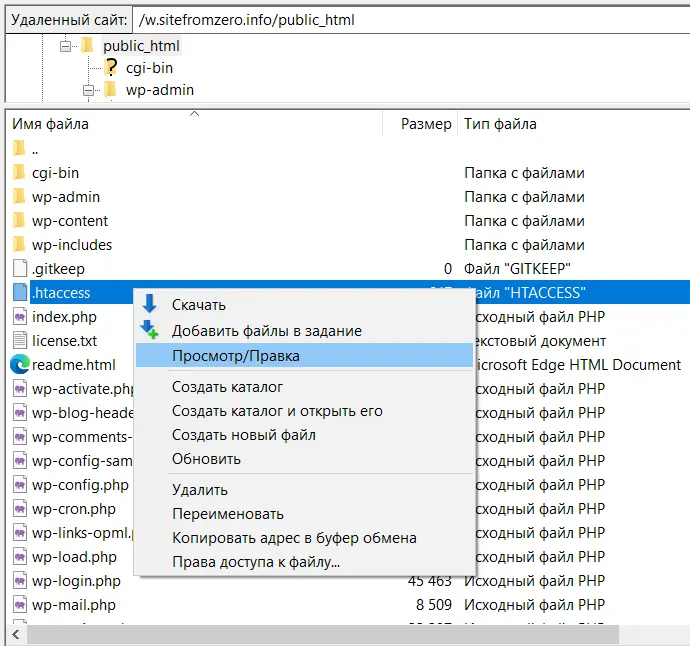

Через файл .htaccess

Якщо ж роботи не реагують на попередні методи, можна внести зміни на рівні сервера за допомогою службового файлу.

Він починається з точки і не є безпосередньо файлом сайту, а служить для налаштувань веб-сервера. Під час встановлення WordPress сам створює .htaccess («hypertext access») у кореневій папці. Ви можете відредагувати його безпосередньо на панелі керування хостингом або через FTP, використовуючи FileZilla.

У цьому випадку прописується заборона кожної пошукової системи.

SetEnvIfNoCase User-Agent "^Yandex" search_bot

SetEnvIfNoCase User-Agent "^Googlebot" search_bot

SetEnvIfNoCase User-Agent "^Yahoo" search_bot

SetEnvIfNoCase User-Agent "^igdeSpyder" search_bot

SetEnvIfNoCase User-Agent "^Robot" search_bot

SetEnvIfNoCase User-Agent "^msnbot" search_bot

SetEnvIfNoCase User-Agent "^Aport" search_bot

SetEnvIfNoCase User-Agent "^Mail" search_bot

SetEnvIfNoCase User-Agent "^bot" search_bot

SetEnvIfNoCase User-Agent "^spider" search_bot

SetEnvIfNoCase User-Agent "^php" search_bot

SetEnvIfNoCase User-Agent "^Snapbot" search_bot

SetEnvIfNoCase User-Agent "^WordPress" search_bot

SetEnvIfNoCase User-Agent "^BlogPulseLive" search_bot

SetEnvIfNoCase User-Agent "^Parser" search_botЦе досить жорсткий метод блокування, який використовується досвідченими вебмайстрами.

Встановити пароль на весь сайт

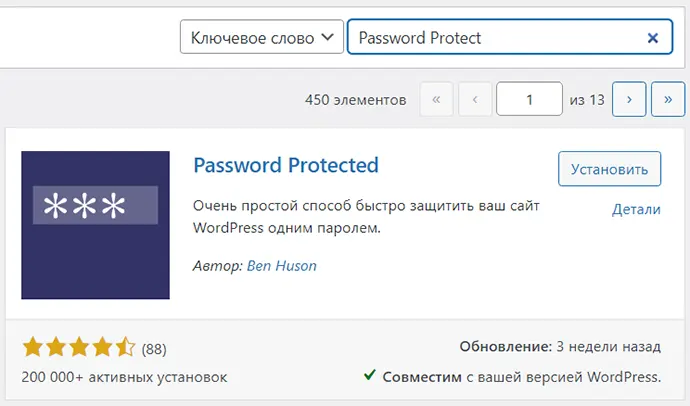

Найнадійніший спосіб закрити сайт від індексації – встановити пароль. Є кілька плагінів WordPress, найбільш простий та популярний – Password Protected.

Адміністратор та зареєстровані користувачі можуть входити без пароля.

Як перевірити які сторінки потрапили до пошуку

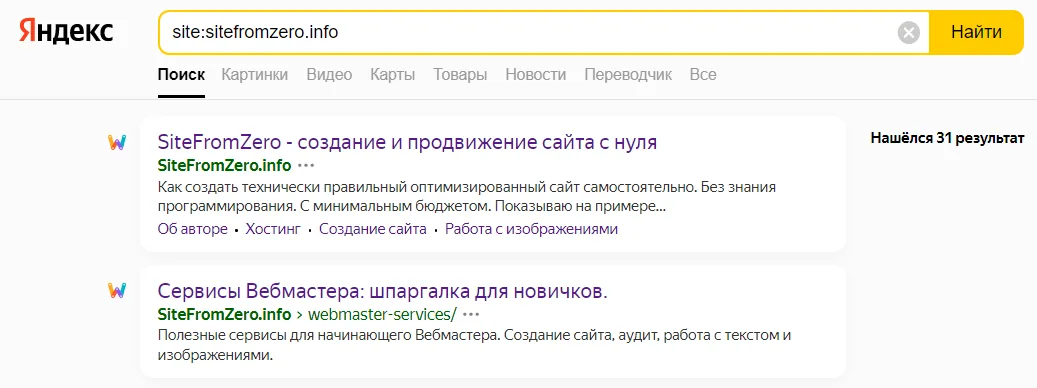

Іноді так трапляється, що незважаючи на заборону, небажаний контент потрапив у видачу. Для перевірки індексації всього проекту можна скористатися пошуковим оператором [site:]. Цей спосіб найпростіший, але не дуже точний.

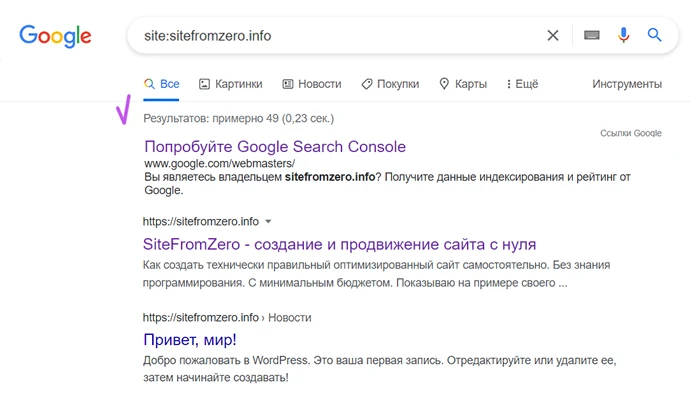

У рядок пошуку Google та Яндекса потрібно ввести такий запит: site:domain.info

За запитом в Яндексі я отримала 31 результат.

При аналогічному запиті Google отримала набагато більше проіндексованих сторінок. Серед них виявилися віддалені сторінки, наприклад, перша пробна стаття “Привіт, мир!”, яка йшла разом із завантаженням WordPress.

Як бачите, Yandex досить слухняний і дотримується правил, чого не скажеш про Googlebot. Тож не думайте, що проект ніхто не знайде. Якщо ви відкрили його в браузері, цього достатньо, щоб «засвітитися».

Як видалити сторінку з пошуку

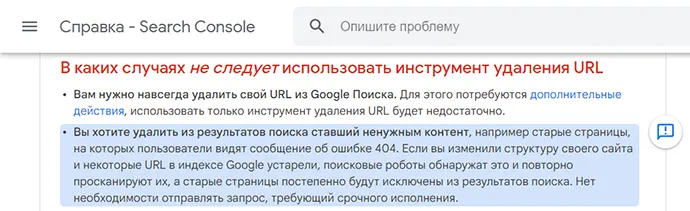

Якщо проект тільки створений і там немає важливої інформації у вигляді персональних даних, то можна нічого не робити, а просто почекати, поки краулери самі виявлять неіснуючі сторінки і видалять їх з пошуку.

Сам Google просить не створювати термінових запитів видалення URL, якщо зайві сторінки виникли внаслідок зміни структури сайту.

Якщо необхідно терміново видалити URL-адресу, то скористайтеся спеціальними інструментами в кабінетах Вебмайстра від Google та Яндекс. Як це зробити, я докладно опишу у новому огляді.

Отже, тепер ви знаєте кілька простих способів, як закрити сайт від індексації, головне не забудьте потім відкрити доступ. Раджу додатково вивчити рекомендації від Google та Яндекс.

У деяких випадках потрібно заборонити індексацію не всього проекту, а лише окремі сторінки або елементи. Про це ми поговоримо іншим разом. Підписуйтесь на оновлення, щоб не пропустити нові публікації.